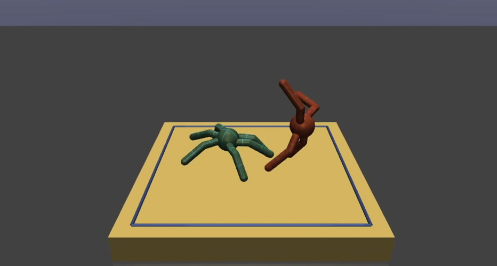

OpenAI研究 摔跤元学习

我们表明,对于模拟机器人摔跤的任务,元学习代理可以学会快速击败更强大的非元学习代理,还表明元学习代理可以适应身体故障。

我们扩展了 与模型无关的元学习 (MAML) 算法,将其目标函数基于成对环境的优化,而不是像现有 MAML 中的单个环境。MAML 初始化我们代理的策略,以便在新环境(或任务)执行期间仅更新少量参数后,代理学习在该环境中做得更好。执行时的策略参数更新是通过在与新环境初始交互的几集中收集的奖励的梯度上升步骤完成的。通过成对训练,我们能够创建快速适应以前未见过的环境的策略,只要环境与以前的环境没有太大差异。

为了测试我们的持续适应方法,我们设计了 3 种类型的智能体——蚂蚁(4 条腿)、虫子(6 条腿)和蜘蛛(8 条腿)——并设置了一个多轮游戏,每个智能体与对手进行多场比赛同一个对手,并在两轮之间调整其政策参数,以更好地对抗对手的政策。在测试中,我们发现与具有固定策略的代理相比,可以调整其策略的代理是更好的竞争者。在训练了一百多个代理人(其中一些学习了固定策略而另一些学习了适应性策略)之后,我们评估了每个代理人的适应性。

即时学习还可以让代理人处理自己身体的异常变化,比如适应自己的一些肢体随着时间的推移失去功能。这表明我们可以使用这样的技术来开发能够处理外部环境变化以及自身身体或内部状态变化的代理。

<

我们正在探索元学习,作为我们大规模多代理研究工作的一部分。此外,我们还 发布了这项工作中使用的 MuJoCo 环境和训练有素的策略 ,以便其他人可以试验这些系统。