OpenAI研究 通过教学进行可解释的机器学习

设计了一种方法,鼓励 AI 使用对人类也有意义的示例相互教学。我们的方法会自动选择信息量最大的示例来教授概念——例如,描述狗概念的最佳图像——并且通过实验,我们发现我们的方法在教授两种 AI 方面都很有效

强大的人工智能的一些最具变革性的应用将来自计算机和人类的合作,但让他们说一种共同的语言是很困难的。想一想当你只看到矩形内的一组随机点时试图猜测矩形的形状:当你在矩形的角上给出点时,找出矩形的正确尺寸要快得多. 我们的机器教学方法是在两个代理之间进行的合作游戏,其中一个充当学生,另一个充当老师。游戏的目标是让学生根据特定概念的例子(例如狗的图像)猜测一个特定的概念(即“狗”、“斑马”),而教师的目标是学会选择对学生最具说明性的例子。

我们的两阶段技术是这样工作的:给“学生”神经网络随机选择的概念输入示例,并使用传统的监督学习方法从这些示例中训练以猜测正确的概念标签。在第二步中,我们让“教师”网络——它有一个要教授的概念并可以访问将概念链接到示例的标签——在学生身上测试不同的示例,看看学生给他们分配了哪些概念标签,最终收敛到它需要给出的最小示例集让学生猜测预期的概念。这些例子最终看起来是可以解释的,因为它们仍然基于概念(通过第一步中训练的学生)。

相比之下,如果我们联合训练学生和老师(就像在许多当前的交流游戏中所做的那样),学生和老师可以串通通过对人类没有意义的任意示例进行交流。例如,“狗”的概念最终可能会通过一些任意向量进行编码,这些向量可能显示美洲驼和摩托车的图像,或者一个矩形可能由两个点组成,这些点在人类看来是随机的,但编码了特定矩形的方面。

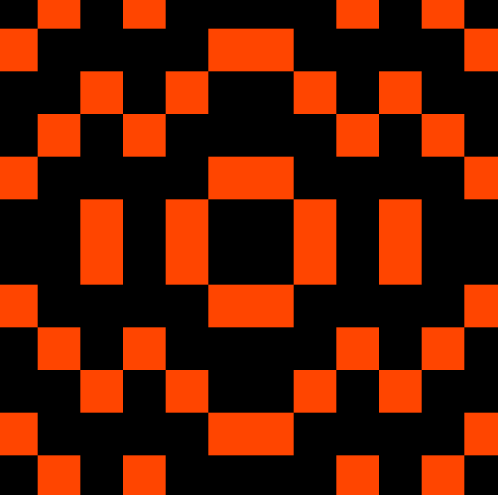

要理解我们的技术为何有效,请考虑当我们使用我们的方法教学生从示例图像中识别概念时会发生什么,这些概念根据四个属性而变化:大小(小、中、大)、颜色(红色、蓝色、绿色)、形状(正方形与圆形)和边框(实心与无)。

在这种情况下,概念是一组属性,这些属性将示例的子集定义为属于该概念;例如,如果概念是红色圆圈,则任何大小或边框的红色圆圈都适合该概念。我们的教师网络最终会学会挑选那些唯一的共同属性是概念所要求的例子,这样学生就可以排除不相关的属性。例如,为了传授“红色”的概念,我们的老师选择了一个没有边框的大红色方块,然后选择了一个有边框的红色小圆圈。这两种形状唯一的共同点是红色,因此这个概念必须只包含红色。

这种方法适用于布尔、层次、概率和基于规则的概念,教师网络发明的教学技术经常反映人类设计的最佳策略。我们还通过给他们提供教师网络生成的示例来评估我们对人类的方法。我们发现,在我们的机器老师给出示例的 Mechanical Turk 上,人类受试者能够比仅向他们提供随机示例来指导他们更频繁地猜出正确的概念。

虽然我们在这项工作中只通过示例来研究教学,但这些想法可以应用于在代理之间创建可解释的通信或我们希望使代理之间的交互更容易被人类理解的其他方式。